Những cơn hoảng loạn đã trở thành chuyện phổ biến. Các nhân viên đùa bỡn về việc tự tử, quan hệ tình dục trên cầu thang, và hút cần sa trong giờ giải lao.

Một bài báo điều tra của The Verge tuần trước đã tiết lộ một hiện tượng đáng lo ngại rằng một số nhân viên kiểm duyệt làm việc theo hợp đồng của Facebook – những người được giao nhiệm vụ quét sạch những nội dung như video chặt đầu, hành động thú tính hay phân biệt chủng tộc khỏi New Feeds của bạn – đã phải tìm tới những cơ chế đối phó cực đoan để vượt qua những ngày làm việc. Một số nhân viên hợp đồng đã bị ảnh hưởng sâu sắc bởi những nội dung họ tiếp xúc, và điều đó có thể là một ngụ ý cho tất cả chúng ta, những người đã quen với việc kéo qua những liên kết sơ sài trên trang News Feed.

Với một số nhân viên, việc liên tục xem những video thuyết âm mưu và những hình meme đã trở thành cửa ngõ dẫn họ đến việc chấp nhận những thuyết âm mưu. Các nhà thầu chia sẻ với nhà báo Casey Newton của The Verge rằng một số đồng nghiệp của họ sẽ “về phe quan điểm thiểu số” sau nhiều ngày bị vây quanh bởi những video và meme như vậy.

“Một quản lý đánh giá chất lượng đi đi lại lại trên sàn nhà để kiểm chứng tư tưởng rằng Trái Đất là hình phẳng,” Newton viết.

Với một số nhân viên, việc liên tục xem những video thuyết âm mưu và những hình meme đã trở thành cửa ngõ dẫn họ đến việc chấp nhận những thuyết âm mưu.

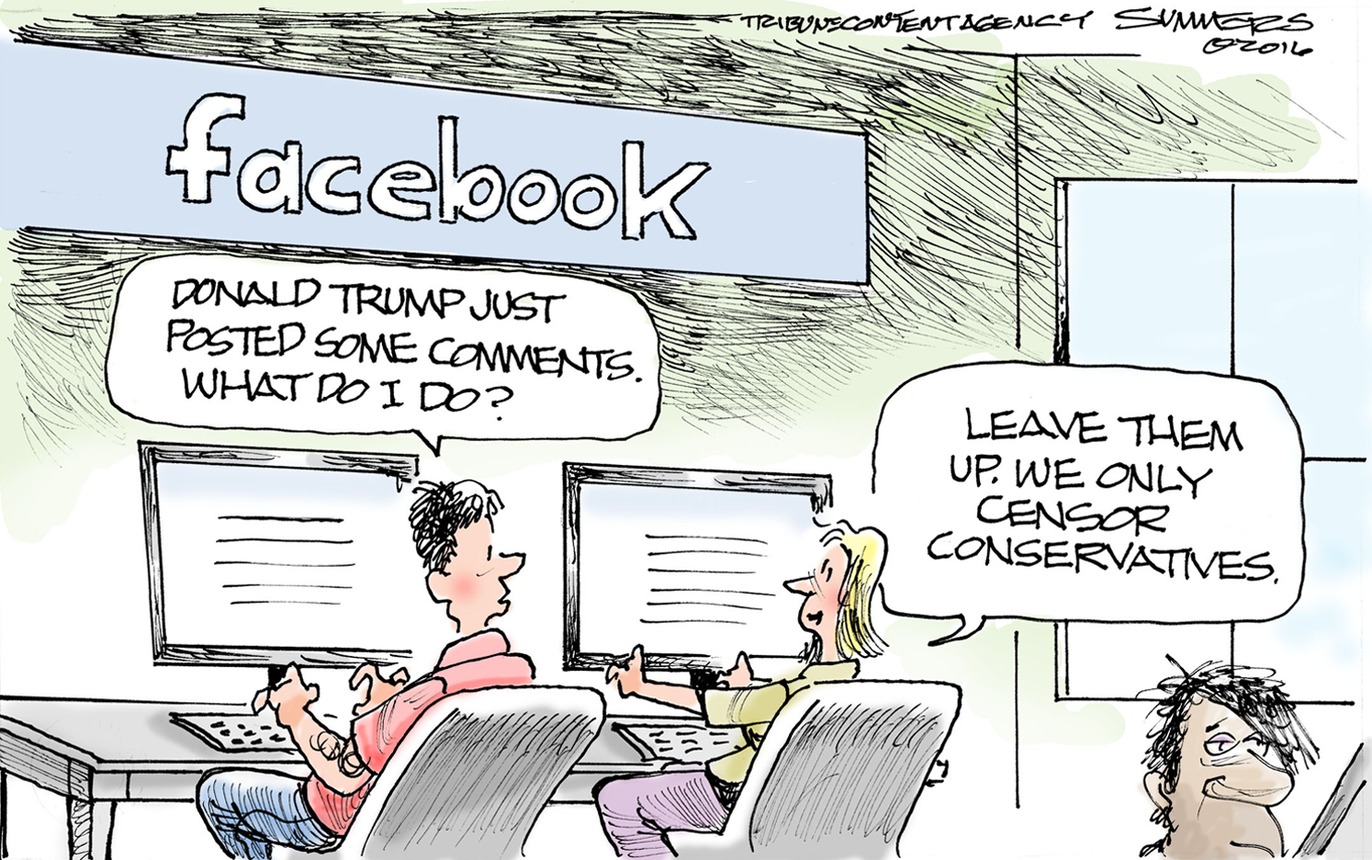

Căn cứ theo các quy tắc của Facebook, hầu hết những thông tin sai lệch đều không bị cấm, do đó nhìn chung Facebook sẽ không lập tức xóa bỏ chúng, với lập luận rằng cần có các báo cáo thực tế để phản bác các nội dung này. Những nỗ lực như vậy không hoàn toàn thành công: Một bài báo gần đây trên tờ Guardian đã phát hiện ra rằng “những kết quả tìm kiếm nhóm và trang với thông tin về vắc xin đã bị chi phối bởi hoạt động tuyên truyền chống tiêm vắc xin” trên mạng xã hội này.

Đương nhiên, đây không chỉ là vấn đề của riêng Facebook. Một cuốn sách về thuyết âm mưu Qanon, được tiếp sức bởi các thuật toán của Amazon, đang nhanh chóng leo lên bảng xếp hạng doanh số của trang web này. Hôm thứ Sáu vừa qua, Youtube đã thông báo sẽ chặn các quảng cáo từ tất cả các video có hình ảnh Momo – một nhân vật với vẻ ngoài đáng sợ đưa ra những lời hướng dẫn trẻ em tự làm hại mình hoặc tự sát trong một “thử thách” trên mạng. Điều đó cũng chẳng ngăn chặn được sự lan rộng của những nội dung chứa Momo.

Cái gì có thể khiến một người có suy nghĩ logic chấp nhận những điều này? Nếu những nhân viên kiểm duyệt của Facebook – những người được đào tạo để xem những nội dung có vấn đề này – bị ảnh hưởng một cách nghiêm trọng như thế, vậy còn hy vọng gì cho chúng ta?

Ở đây có sự tham gia của một số yếu tố tâm lý học. Mọi người có xu hướng phát triển một sự ưu tiên cho những ý kiến mà họ quen thuộc – một hiện tượng khoa học xã hội được gọi là hiệu ứng tiếp xúc thường xuyên hay nguyên tắc sự quen thuộc. Chiếu theo đó, tư tưởng cũng gần giống như virus truyền nhiễm.

“Càng thường xuyên thấy chúng, bạn sẽ càng thấy chúng quen thuộc, và khi một thứ gì đó trở nên ngày càng quen thuộc, thì sự đáng tin của nó cũng sẽ tăng lên,” Jeff Hancock, giáo sư truyền thông kiêm giám đốc sáng lập Phòng thí nghiệm truyền thông xã hội Stanford cho biết.

“Càng thường xuyên thấy chúng, bạn sẽ càng thấy chúng quen thuộc, và khi một thứ gì đó trở nên ngày càng quen thuộc, thì sự đáng tin của nó cũng sẽ tăng lên.”

Nội dung của các thuyết âm mưu được thiết kế để có sức thuyết phục. Mọi người chấp nhận những thuyết này vì chúng giúp lý giải một thế giới đầy những sự ngẫu nhiên; và cho dù chúng ta cảm thấy chúng đã đi quá xa, thì chúng vẫn có thể mang lại một chút cảm giác về sự thoải mái và an toàn. Và việc thấy những thuyết đó liên tục xuất hiện trên News Feed của bạn “dần dần làm suy yếu cảm giác về sự nhảm nhí của chúng,” theo James Grimmelmann, một giáo sư tại Đại học Luật Cornell, chuyên nghiên cứu về luật Internet và các mạng xã hội.

Mặc dù người dùng Facebook có thể cảm thấy bị xúc phạm khi lần đầu thấy một video phản cảm trên trang của họ, nhưng ít có khả năng họ sẽ nảy sinh phản ứng tiêu cực về mặt cảm xúc tương đương nếu trải nghiệm đó được lặp đi lặp lại. Một khi đã xem đủ, họ có thể sẽ thấy thông điệp đó đúng ý mình, hoặc ít nhất cũng không chói tai. Chỉ cần một khe hở nhỏ khi mở cửa vào tâm trí bạn cũng đủ để thuyết âm mưu lách vào.

“Sự tiếp xúc lặp đi lặp lại cũng có thể khiến các nhân viên kiểm duyệt nghĩ rằng thuyết âm mưu phổ biến hơn so với thực tế, và từ đó dần dần khiến họ ủng hộ nó,” Dominique Brossard, giáo sư bộ môn giao tiếp khoa học đời sống tại Đại học Wisconsin-Madison cho hay. “Đó là lý do khiến những chuẩn mực xã hội có một sức mạnh rất lớn.”

Nếu những niềm tin đó được thấm nhuần, mọi người sẽ nỗ lực để củng cố chúng, đơn giản vì chúng ta có xu hướng cố gắng hơn để bảo vệ những quan điểm của mình. “Một khi bạn bắt đầu tin tưởng, thiên kiến xác nhận sẽ nảy sinh,” giáo sư Hancock nói về xu hướng tìm kiếm thông tin hoặc những nguồn tin tức ủng hộ niềm tin đã có sẵn từ trước của con người.

Một yếu tố đóng góp nhỏ hơn có thể là hiện tượng tâm lý được gọi là sự truyền nhiễm cảm xúc, tức là khi những cảm xúc được lan truyền từ người này sang người khác. Bạn có thể không biết thuật ngữ này, nhưng bạn biết cảm giác đó. Hiện tượng vô tình bắt chước biểu cảm gương mặt hay phản chiếu tâm trạng của một người mà bạn đang dành thời gian ở cùng là những ví dụ về truyền nhiễm cảm xúc.

“Một khi bạn bắt đầu tin tưởng, thiên kiến xác nhận sẽ nảy sinh.”

Có thể những video thuyết âm mưu làm thấm nhuần hoặc gieo rắc nỗi sợ hãi cho người xem, và sau khi phản chiếu lại cảm xúc đó, họ sẽ tìm cách gán nỗi sợ không giải thích được đó cho một nguồn hữu hình. “Tôi đang cảm thấy kỳ quặc, ghê tởm và sợ hãi. Tại sao lại như vậy? ‘ Hopkins hỏi như một giả thuyết. “’Có lẽ là vì chính phủ đang chống lại chúng ta.’ Bạn đang hợp lý hóa lý do vì sao bạn thấy khó chịu” – ngay cả khi điều khiến bạn khó chịu ngay từ đầu là nội dung của thuyết âm mưu đó.

Mặc dù sự căng thẳng tâm lý hết sức của các nhân viên kiểm duyệt của Facebook liên quan nhiều tới số lượng lớn những nội dung khó chịu mà họ phải tiếp xúc trong công việc – một nhân viên kiểm duyệt trả lời phỏng vấn của The Verge phải lướt qua tới 400 bài đăng mỗi ngày – Facebook vẫn có thể hiện những nội dung thuyết âm mưu hay đơn giản chỉ là những video, tin tức và meme sai lệch.

Sự tiếp xúc tập thể của chúng ta với nội dung âm mưu trên Facebook có ý nghĩa gì với sức khỏe tâm thần công cộng nói chung? Có phải chúng ta chỉ còn thiếu vài cú kích chuột để trở thành “những kẻ tin rằng Trái Đất phẳng” – hay tệ hơn thế?

Joseph Walther, giám đốc Trung tâm Công nghệ và An toàn thông tin tại Đại học California-Santa Barbara, đã cảnh báo bằng việc ngoại suy từ trải nghiệm khắc nghiệt của các nhân viên kiểm duyệt Facebook. Nếu một người dùng mạng xã hội bình thường giống như một người hay hút thuốc bình thường, các nhân viên kiểm duyệt đang tiêu thụ lượng nội dung tương đương hút hai bao thuốc lá mỗi ngày.

Nếu một người dùng mạng xã hội bình thường giống như một người hay hút thuốc bình thường, các nhân viên kiểm duyệt đang tiêu thụ lượng nội dung tương đương hút hai bao thuốc lá mỗi ngày.

“Nhưng nhân viên kiểm duyệt mà bạn mô tả, họ thực sự đang bị hành hạ,” Walther nói với OneZero. “Mức độ tiếp xúc của họ với những thông điệp đó không giống bình thường. Và trải nghiệm của họ cũng không thể áp dụng cho tất cả chúng ta.”

Sự khác biệt cơ bản nhất giữa những cá nhân không bị ảnh hưởng bởi nội dung âm mưu và những người được truyền bá những nội dung đó có thể là những gì xảy ra với họ khi họ không trực tuyến. Một cú đánh mạnh vào cái tôi của một cá nhân, chẳng hạn như bị đuổi việc hay bị người mình thích từ chối, có thể khiến một số người hướng tới sự phân biệt chủng tộc hay các thuyết âm mưu – những thứ này, theo Walther, là thường đan xen lẫn nhau. Khi bị tổn thương, con người sẽ muốn tìm một vật tế thần.

“Nếu họ đã thiên về tư tưởng phân biệt chủng tộc, và nhận thấy một số mối đe dọa với địa vị hay sự thuần khiết hay đặc quyền của chủng tộc hay giới tính của họ, và rồi trải qua một sự tổn thương cụ thể, những thuyết âm mưu sẽ trở nên đặc biệt hấp dẫn,” ông nói. “Các thuyết âm mưu giải phóng con người khỏi trách nhiệm với sự bất hạnh của chính họ.”

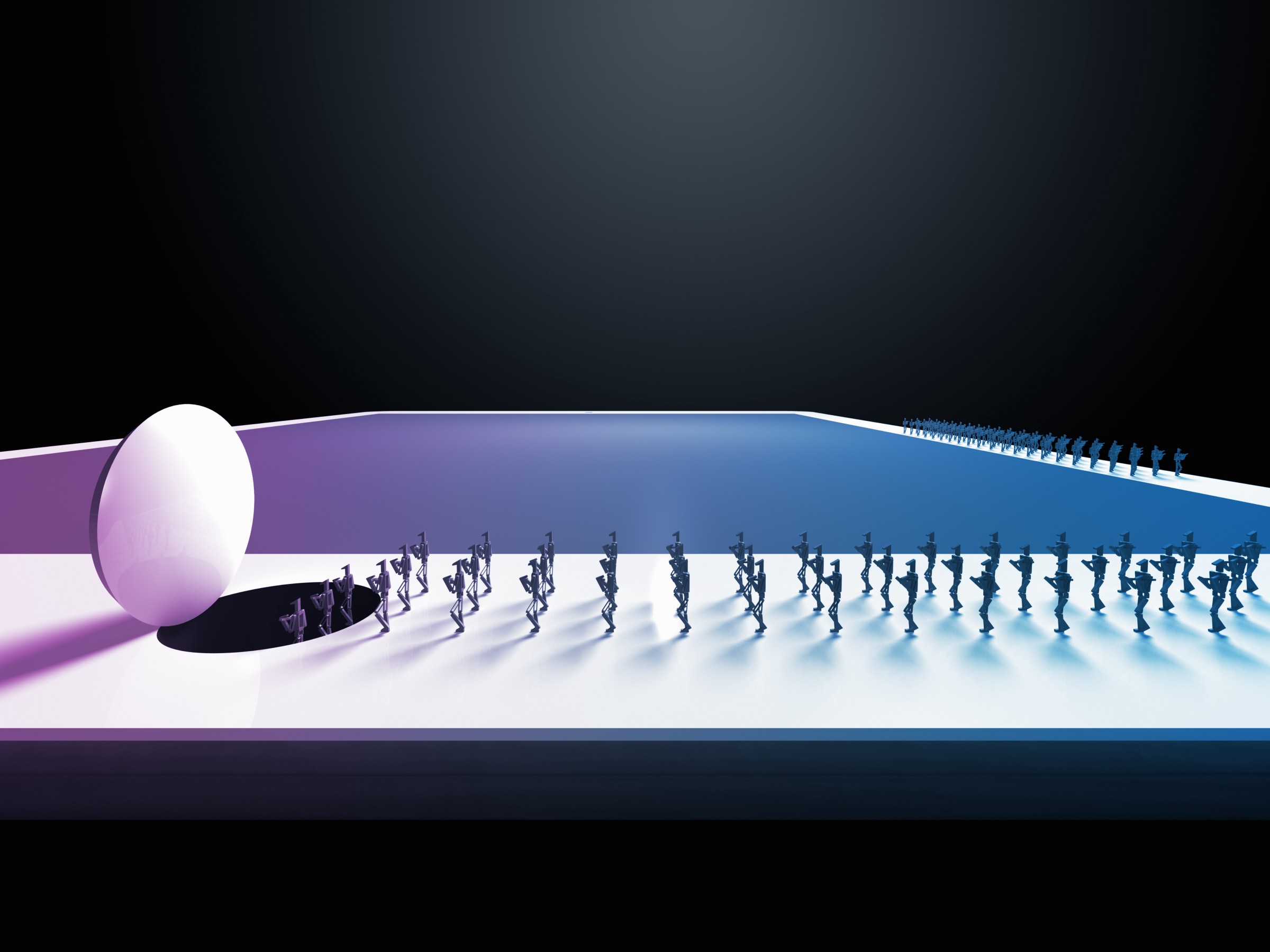

Petter Tornberg, một nhà xã hội học tại Đại học Amsterdam ở Hà Lan, so sánh sự lan truyền của thông tin sai lệch trên mạng xã hội với một vụ cháy rừng. “Một buồng vang có tác dụng tương tự như một đống bùi nhùi khô trong rừng,” Tornberg nói với OneZero. “Nó cung cấp nhiên liệu cho một ngọn lửa nhỏ ban đầu, mà sau đó có thể lan tới những que củi, cành cây và thân cây lớn hơn, để cuối cùng nhấn chìm cả khu rừng trong biển lửa.”

Việc mạng xã hội như Facebook có xu hướng tạo ra một buồng vang – hay như Eli Pariser đã gọi là một “bong bóng lọc” – không phải là ngẫu nhiên. Đó là kết quả tất yếu của kinh tế sức chú ý.

“Vì các nền tảng trực tuyến hoạt động dựa trên quảng cáo, chúng vận hành trong một môi trường mà ở đó chúng phải cạnh tranh để thu hút sự chú ý,” Tornberg nhận định. Sự phẫn nộ và tức giận là những cách hiệu quả để tối đa hóa sự chú ý của người xem – mọi người tương tác và chia sẻ những chuyện giật gân ở một quy mô lớn đến mức làm xuất hiện ngành công nghiêp của những nội dung không có ý nghĩa gì trên mạng xã hội, ở đó “tin rác” có thể thúc đẩy tần số hiển thị quảng cáo. Có rất ít động lực để các nền tảng như Facebook không khuyến khích người dùng ngả về những nhóm lợi ích nhỏ khi các nội dung thái quá được chia sẻ.

Mặc dù công chúng nói chung ít có rủi ro bị thuyết phục bởi thuyết âm mưu hơn các nhân viên kiểm duyệt Facebook, điều đó không có nghĩa là không tồn tại rủi ro cho sức khỏe cộng đồng.

“Truyền thông xã hội không nhất thiết phải được thiết kế để thúc đẩy chúng ta hướng tới bộ lạc hóa và tự tách biệt,” Tornberg chia sẻ. “Chúng cũng có thể được thiết kế để giúp hình thành nền móng cho một thế giới chung.” Ông lấy ví dụ về cộng đồng “Change My View” (Thay đổi quan điểm của tôi) trên Reddit, ở đó người dùng đăng các ý kiến mà họ cho là có thể còn thiếu sót với hy vọng là có một cuộc thảo luận và thấu hiểu các quan điểm khác.

“Nhưng điều đó sẽ đòi hỏi những sự khích lệ khác nhau cho các công ty đứng đằng sau.” Và ngay lúc này, các mạng xã hội như Facebook – với doanh thu 22 tỷ USD trong năm 2018, tăng gần 40% so với năm trước – đang thực hiện rất hiệu quả công việc tối đa hóa những khuyến khích kinh tế hiện tại.

Tự động hóa hoạt động kiểm duyệt nội dung sẽ giúp con người tránh khỏi những tác động có khả năng gây tổn hại khi xem một lượng lớn những video gây khó chịu và những bài đăng thuyết âm mưu. Nhưng trong khi trí tuệ nhân tạo dường như là một giải pháp rõ ràng để giảm sự tiếp xúc của các nhân viên kiểm duyệt và công chúng với các thuyết âm mưu – mặc dù phải đánh đổi bằng công ăn việc làm của rất nhiều nhân viên kiểm duyệt – giáo sư Hancock nói rằng công nghệ như thế vẫn chưa ra đời.

“Con người đang phát triển và sản xuất những nội dung này,” ông nói. “Trong một khoảng thời gian dài nữa, con người vẫn sẽ là những người duy nhất có thể đưa ra những phán đoán này.”

Điều này một phần là vì, theo định nghĩa, những bài đăng bị đánh dấu vi phạm trên Facebook là không điển hình, và AI hiện tại không hoạt động tốt với những nội dung không điển hình. “Khó mà đoán trước được nhiều loại nội dung mà họ thấy,” giáo sư Hancock nói. “Một phần là vì đó là những thứ nhảm nhỉ.”

Các nội dung nhảm nhí khiến chúng ta ngạc nhiên vì tính bất thường của chúng, và máy tính thì chỉ được đào tạo để phản ứng với những tình huống chúng từng gặp phải trước đây. Trên thực tế, lúc này việc đào tạo một cỗ máy phản ứng với những thuyết âm mưu chưa được tưởng tượng ra là chuyện không thể.

Giáo sư Grimmelmann cho rằng sự tồn tại của hoạt động kiểm duyệt nội dung như một nghề nghiệp là một điều xấu cần thiết để bảo vệ sức khỏe tâm thần của cộng đồng lớn hơn – chừng nào mà cộng đồng đó vẫn còn nghiện truyền thông xã hội như hiện tại.

“Đây chính là chủ nghĩa tư bản,” ông nói. “Có những công việc không dễ chịu, ví dụ như dọn cống. Chúng ta muốn những thứ mà công việc đó mang lại.”

Tuy nhiên, chỉ vì một công việc không dễ chịu được xã hội cần đến không có nghĩa là những người sử dụng lao động không làm gì để cải thiện các điều kiện làm việc. Giáo sư Grimmelmann tin rằng công chúng nên gây áp lực để các nền tảng như Facebook cam kết loại bỏ các thuyết âm mưu khỏi trang News Feed của người dùng và bảo đảm rằng nhưng nhân viên kiểm duyệt nội dung của họ có được sự hỗ trợ cần thiết để bảo vệ cho tất cả chúng ta, bao gồm việc giảm khối lượng công việc, hỗ trợ nhiều hơn về mặt cảm xúc, và trả lương cao hơn. (Theo The Verge, các nhân viên hợp đồng của Cognizant chỉ kiếm được 28.800 USD mỗi năm).

Và điều đó có nghĩa là sẽ cần nhiều hơn, thay vì ít đi, những người tham gia vào công việc kiểm duyệt nội dung. “Thật không may, công việc này sẽ trở thành một ngành công nghiệp lớn hơn rất nhiều,” Hancock nói.

Những gì chúng ta đang thấy lúc này chỉ mới là sự khởi đầu. Chỉ riêng Facebook đã có 30.000 nhân viên phụ trách về độ tin cậy và an toàn, bao gồm cả nhân viên hợp đồng. Một nửa trong số này làm công tác kiểm duyệt nội dung, và khoản đầu tư vào hoạt động đánh giá nội dung gần như chắc chắn sẽ tiếp tục phình to.

“Chúng tôi đã tăng hơn gấp đôi đội ngũ suốt hai năm qua, bổ sung thêm hàng nghìn người cho nỗ lực này,” Justin Osofsky, phó chủ tịch Hoạt động toàn cầu của Facebook viết trong một bài đăng ngày 25/2.

Vì vậy, giống như khi con người tạo ra những vấn đề này – bằng cách khai thác một nên tảng để truyền bá các thuyết âm mưu và những nội dung đáng lo ngại khác – con người sẽ phải giải quyết chúng. Không quy trình tự động nào có thể lường trước được mọi hoán vị nội dung rác mà chúng ta có thể nghĩ ra.

Hay như Hancock nhận định: “Tôi không nghĩ con người sẽ phải ra rìa.”