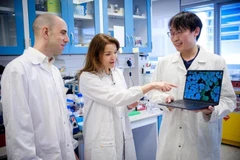

Sự phát triển nhanh chóng của AI đang khơi dậy cuộc thảo luận về khả năng ứng dụng của nó trong điều trị bệnh tâm thần (Nguồn: Getty Images)

Sự phát triển nhanh chóng của AI đang khơi dậy cuộc thảo luận về khả năng ứng dụng của nó trong điều trị bệnh tâm thần (Nguồn: Getty Images)

Triển vọng của việc dùng AI để điều trị bệnh tâm thần đang thu hút nhiều sự quan tâm, cũng như nêu ra các câu hỏi liên quan tới đạo đức và tính thực tiễn.

Nếu người dùng nhập câu “Tôi cảm thấy lo lắng” vào giao diện làm việc với ChatGPT, chatbot trang bị trí tuệ nhân tạo (AI) của công ty OpenAI sẽ có phản ứng khiến họ bất ngờ.

“Tôi rất tiếc khi biết rằng bạn đang cảm thấy lo lắng,” dòng chữ chạy nhanh trên màn hình cho thấy câu trả lời của chatbot. “Có thể bạn đang gặp phải một trải nghiệm đầy khó khăn, nhưng vẫn còn nhiều cách mà bạn có thể thử kiểm soát các triệu chứng của mình.”

Sau đó, một danh sách các khuyến nghị được đánh số thứ tự sẽ hiện ra, bao gồm tập thư giãn, tập trung vào giấc ngủ, cắt giảm lượng caffein và rượu nạp vào cơ thể, chống lại những suy nghĩ tiêu cực và tìm kiếm sự hỗ trợ của bạn bè cùng gia đình.

Mặc dù đó không phải là những lời khuyên mới nhất, nhưng chúng khá giống với những gì mà người ta có thể nhận được từ phòng khám của một nhà trị liệu tâm lý, hoặc trong nội dung của các bài báo có nhiều người đọc, viết về cách kiểm soát sự lo lắng.

Sử dụng ChatGPT trong điều trị tâm lý

ChatGPT tự đưa ra cảnh báo với người dùng rằng nó không thể thay thế vai trò của một nhà tâm lý học, hoặc bác sỹ tư vấn tâm lý chuyên nghiệp. Nhưng điều này không ngăn được thực tế là ngày càng có nhiều người sử dụng ChatGPT như một “bác sỹ” trị liệu tâm lý riêng của họ.

Nhiều bài viết đã xuất hiện trên các diễn đàn trực tuyến dạng như Reddit, trong đó người dùng mô tả lại trải nghiệm của họ khi yêu cầu ChatGPT cho lời khuyên về các vấn đề cá nhân, hoặc các sự kiện khó khăn trong cuộc sống như chia tay với người yêu.

Một số người đánh giá trải nghiệm của họ với chatbot này tốt ngang với hoạt động điều trị tâm lý truyền thống, thậm chí tốt hơn.

Khả năng đáng kinh ngạc của ChatGPT trong việc bắt chước cuộc trò chuyện của con người đã đặt ra câu hỏi về tiềm năng sử dụng AI để điều trị nhiều chứng bệnh về tinh thần, đặc biệt là ở những khu vực như châu Á, nơi các dịch vụ chăm sóc sức khỏe tinh thần còn thưa thớt và chưa được quan tâm đúng mức.

Một số người đam mê AI thấy rằng chatbot có tiềm năng lớn nhất trong việc điều trị các chứng bệnh nhẹ, thường gặp, như tình trạng lo lắng và trầm cảm.

Phương pháp điều trị tiêu chuẩn cho những bệnh nhẹ như vậy là các nhà trị liệu sẽ lắng nghe cảm xúc của bệnh nhân và đưa ra các biện pháp thực tế để giải quyết vấn đề của họ.

Trên lý thuyết, liệu pháp dựa trên AI có thể cung cấp khả năng hỗ trợ nhanh hơn và rẻ hơn so với các dịch vụ sức khỏe tinh thần truyền thống - thường ở trong tình trạng thiếu người có năng lực điều trị, danh sách bệnh nhân chờ đợi dài và chi phí cao. Đồng thời, nó cho phép những người mắc bệnh tránh được cảm giác e ngại và xấu hổ, đặc biệt là ở những khu vực nơi bệnh tâm thần vẫn là đề tài nhạy cảm.

ChatGPT đã gây bão trên toàn thế giới kể từ khi ra mắt vào tháng 11/2022. (Nguồn: Reuters)

ChatGPT đã gây bão trên toàn thế giới kể từ khi ra mắt vào tháng 11/2022. (Nguồn: Reuters)

Ashley Andreou, một sinh viên y khoa chuyên ngành tâm thần học tại Đại học Georgetown, Canada, chia sẻ với trang tin Al Jazeera: “Trị liệu tâm lý rất tốn kém và đắt đỏ. Danh sách chờ đợi cũng rất dài. Tôi nghĩ rằng AI sáng tạo kết hợp với một chuyên gia y tế có bằng cấp sẽ tăng mạnh hiệu quả chữa trị.”

Những tranh cãi

Tuy nhiên viễn cảnh AI có thể tăng cường, hoặc thậm chí dẫn đầu hoạt động điều trị sức khỏe tinh thần đã đặt ra vô số mối lo ngại về đạo đức cũng như tính thực tiễn.

Những lo ngại này bao gồm việc làm thế nào để bảo vệ thông tin cá nhân và hồ sơ y tế của bệnh nhân, hay liệu một chương trình chạy trên máy tính thực sự có khả năng thấu cảm với bệnh nhân và nhận biết các dấu hiệu cảnh báo cho thấy họ đang mắc bệnh nặng hay không.

Mặc dù công nghệ đằng sau ChatGPT vẫn còn ở giai đoạn sơ khai, nhưng nền tảng này và các đối thủ chatbot khác của nó vẫn đang nỗ lực bắt kịp với con người trong một số lĩnh vực nhất định, chẳng hạn như nhận dạng các câu hỏi có tính lặp cao.

Tuy nhiên chúng có thể đưa ra các câu trả lời không chính xác hoặc gây lo ngại cho một số câu hỏi của người dùng.

Cho đến nay, việc sử dụng AI để điều trị sức khỏe tinh thần vẫn bị giới hạn trong các hệ thống “hoạt động dựa trên luật lệ và quy tắc” thuộc về các loại ứng dụng (app) chăm sóc sức khỏe như Wysa, Heyy và Woebot.

Mặc dù các app này bắt chước nhiều khía cạnh của quy trình trị liệu tiêu chuẩn, chúng chỉ sử dụng một số tổ hợp câu hỏi và đưa ra câu trả lời nhất định, do con người chọn sẵn.

Một số người đam mê AI tin rằng công nghệ này có thể cải thiện việc điều trị các tình trạng sức khỏe tâm thần. (Nguồn: Getty Images)

Một số người đam mê AI tin rằng công nghệ này có thể cải thiện việc điều trị các tình trạng sức khỏe tâm thần. (Nguồn: Getty Images)

Trong khi đó, ChatGPT và các nền tảng khác dựa trên AI sáng tạo lại tạo ra các phản hồi chứa nhiều nội dung mới, giống như do một người thực tạo ra.

Ramakant Vempati, người sáng lập ứng dụng Wysa có trụ sở tại Ấn Độ, cho biết AI sáng tạo vẫn được coi là giống một chiếc “hộp đen” – quá phức tạp đến mức con người không thể hiểu hết quá trình ra quyết định của nó – nên không thể sử dụng trong môi trường điều trị sức khỏe tinh thần.

“Rõ ràng có rất nhiều tài liệu xung quanh việc trò chuyện với AI đang bùng nổ như thế nào, nhất là sau khi ChatGPT ra mắt. Nhưng tôi nghĩ điều quan trọng cần nhấn mạnh là Wysa tập trung vào lĩnh vực cụ thể, được xây dựng rất cẩn thận với các biện pháp đảm bảo an toàn kèm theo,” Vempati nói với Al Jazeera.

“Chúng tôi cũng không sử dụng các hệ thống tự sáng tạo văn bản hay mô hình AI sáng tạo để đưa ra phản hồi với người dùng. Thay vì thế, chúng tôi dùng những cuộc trò chuyện được xây dựng sẵn, ở đó kịch bản được viết trước và xác thực thông qua một bộ dữ liệu về an toàn bệnh nhân, chính nó đã được chúng tôi kiểm tra dựa trên phản ứng của bệnh nhân.”

[Nguy cơ ChatGPT bị lợi dụng để lập trình phần mềm độc hại]

Tính năng đặc trưng của Wysa là nó cho phép bệnh nhân trò chuyện cùng một chú chim cánh cụt nằm trong app. Tuy nhiên các cuộc trò chuyện bị hạn chế và ứng dụng chỉ đưa ra một lượng câu trả lời nhất định, không mở rộng ra như dạng đối thoại tự do của ChatGPT.

Những người đăng ký trả phí cho Wysa sẽ được chuyển đến gặp một chuyên gia tâm lý là con người, nếu các câu hỏi của họ khó dần lên, vượt ngoài khả năng của app.

Ứng dụng Heyy - được phát triển ở Singapore và Woebot ở Mỹ cũng hoạt động theo mô hình tương tự. Các app này dựa vào các nhà trị liệu tâm lý con người và một chatbot với khả năng giao tiếp hạn chế, để tương tác với bệnh nhân.

Cả ba ứng dụng đều vận hành dựa vào liệu pháp hành vi nhận thức, một hình thức điều trị tiêu chuẩn chống lại các chứng lo âu và trầm cảm, tập trung vào việc thay đổi cách suy nghĩ và hành xử của bệnh nhân.

Những người sáng lập cả ba ứng dụng đều nhấn mạnh rằng họ không cố gắng thay thế hoạt động điều trị dựa trên con người. Họ chỉ bổ sung cho các dịch vụ truyền thống và cung cấp một công cụ bổ sung trong điều trị sức khỏe tinh thần.

Tác động tiêu cực

Ngành công nghiệp AI hiện gần như vẫn chưa được điều phối, bất chấp việc đã những quan ngại hình thành quanh chúng. Người ta lo ngại về khả năng lĩnh vực có tốc độ phát triển rất nhanh này sẽ mang tới những rủi ro nghiêm trọng cho sức khỏe con người.

Tháng trước, Giám đốc điều hành Tesla Elon Musk và đồng sáng lập Apple Steve Wozniak đã thêm tên của họ vào danh sách hàng ngàn người ký tên vào một bức thư ngỏ, kêu gọi tạm dừng việc đào tạo các hệ thống AI mạnh hơn GPT- 4, thế hệ tiếp theo của ChatGPT, trong vòng 6 tháng.

Việc này nhằm giúp các nhà nghiên cứu có thời gian nắm bắt tốt hơn về công nghệ mới.

“Các hệ thống AI mạnh mẽ chỉ nên được phát triển khi chúng tôi tin tưởng rằng tác động của chúng là tích cực và chúng ta có thể kiểm soát rủi ro mà chúng mang lại,” bức thư có đoạn.

Đã có những câu chuyện đau lòng liên quan tới AI xuất hiện. Đầu năm nay, một người đàn ông Bỉ được cho là đã tự tử sau khi bị chatbot Chai khuyến khích làm điều này.

Trong diễn biến khác, một nhà báo của New York Times tiết lộ rằng anh đã được chatbot Bing của Microsoft “khuyên” bỏ vợ.

Có thể thấy rằng quy định quản lý AI đang không theo kịp với tốc độ phát triển của công nghệ. Trong khi EU đang nghiên cứu luật phân loại AI thành các nhóm rủi ro cao và bị cấm hay cần được quản lý, Mỹ vẫn chưa có đề xuất luật liên bang để điều chỉnh AI.

Cần thêm thời gian

Hiện tại, cả ChatGPT lẫn các ứng dụng dành riêng cho sức khỏe tinh thần như Wysa và Heyy, đều chịu sự quản lý của các cơ quan giám sát sức khỏe như Cục Quản lý Thực phẩm và Dược phẩm Mỹ hoặc Cơ quan Dược phẩm Châu u.

Có rất ít nghiên cứu độc lập về việc liệu AI có thể vượt ra ngoài các quy tắc mà người ta đã xây dựng trong ứng dụng, để tự cung cấp phương pháp điều trị sức khỏe tinh thần hay không.

Để có thể sánh được với một chuyên gia tâm lý là con người, AI phải có khả năng tái tạo hiện tượng chuyển giao - trong đó bệnh nhân muốn thể hiện cảm xúc thực của họ với chuyên gia tâm lý.

Maria Hennessy, nhà tâm lý học và là giảng viên tại Đại học James Cook cho biết: “Trong tài liệu tâm lý học, chúng tôi biết rằng quan hệ cá nhân giữa chuyên gia trị liệu và bệnh nhân đóng vai trò rất lớn về mức độ hiệu quả của hoạt động trị liệu tâm lý, chiếm từ 40-50%.”

Hennessy cho biết các chatbot hiện tại không có khả năng tương tác kiểu này. Khả năng xử lý ngôn ngữ tự nhiên của ChatGPT, mặc dù rất ấn tượng, nhưng vẫn có giới hạn. “Cuối cùng thì nó vẫn chỉ là một chương trình máy tính tuyệt vời mà thôi” cô nói.

Một số chuyên gia tin rằng AI có thể hữu dụng nhất trong các hoạt động hỗ trợ, chẳng hạn như thực hiện nghiên cứu hoặc giúp các nhà trị liệu con người đánh giá tiến trình điều trị của bệnh nhân.

“Các thuật toán học máy này ưu việt hơn những hệ thống do chuyên gia vận hành chỉ trong hoạt động xác định mẫu dữ liệu,” Tania Manríquez Roa, một nhà đạo đức học tại Viện Đạo đức Y sinh và Lịch sử Y học của Đại học Zurich cho biết.

“Nó rất giỏi trong việc đưa ra các liên kết về dữ liệu, cũng như dự đoán, chẩn đoán dựa trên dữ liệu. Nó có thể hữu dụng trong hoạt động nghiên cứu về sức khỏe tinh thần và có thể giúp xác định sớm các dấu hiệu cho thấy bệnh tái phát như trầm cảm hoặc lo lắng”./.